Bude to stačit? Obrázky vytvořené AI dostanou na Facebooku a Instagramu označení

Společnost Meta vydala prohlášení, ve kterém uvádí, že začne označovat obrázky vytvořené s pomocí umělé inteligence. Jedním z největších bezprostředních nebezpečí spojených s generativní AI je nárůst obsahového balastu, a především pak dezinformací a fake news. Falešný narativ podpořený šikovně „cinklou“ fotografií získává na mnohem větší důvěryhodnosti. I to je důvod, proč se Meta snaží ošetřit označení obrázků, které s pomocí AI vznikly.

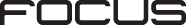

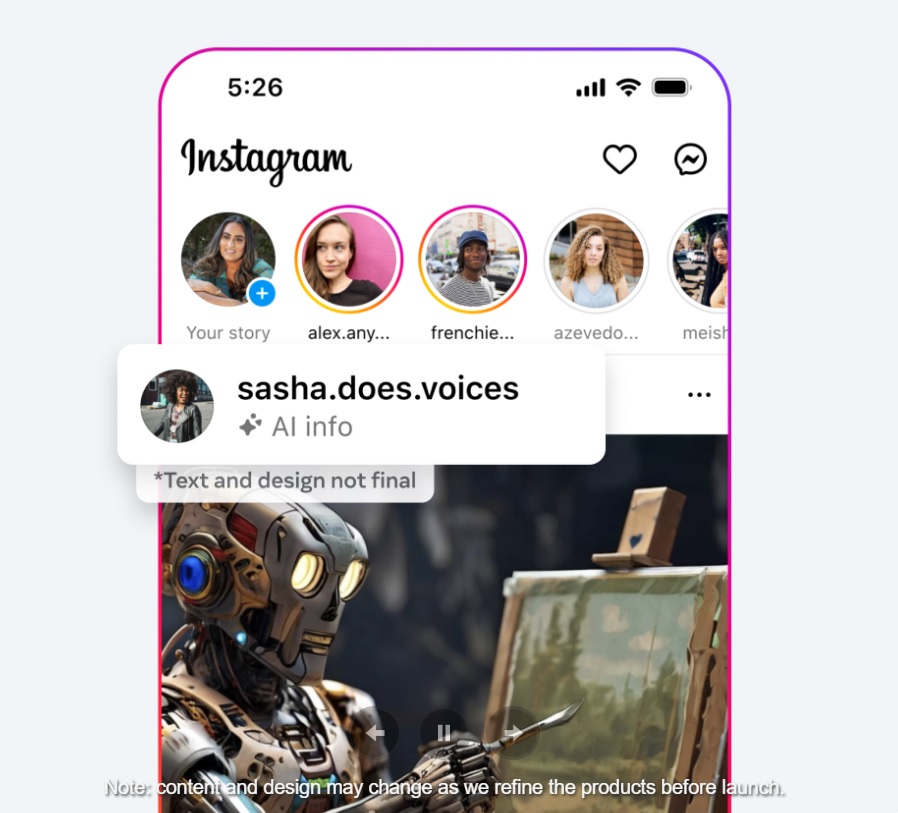

Není to přitom zdaleka pouze iniciativa Meta. Existuje koalice C2PA (Coalition for Content Provenance and Authenticity), jež vytvořila standardy pro označování obrázků vytvořených AI. Zjednodušeně jde o neviditelný „vodoznak“, který je k dispozici v metadatech snímku, a zároveň také označení viditelné i pro běžného diváka. Tyto atributy by měly nově splňovat na Facebooku i Instagramu fotky vytvořené s pomocí AI. Není zcela jasná podoba viditelného označení, je možné, že bude mimo samotnou oblast fotografie nad ní, podobně jako štítek „placená spolupráce“ značí obchodní vztah mezi influencerem a značkou, která ho platí za reklamu.

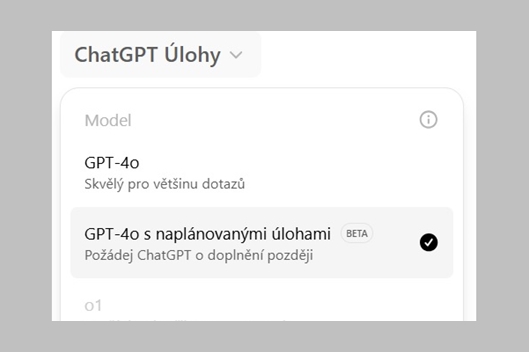

S minimálním časovým posunem od Meta oznámila přijetí těchto standardů i společnost Open AI, která vlastní mimo AI chatbota ChatGPT také nástroj pro generování obrázků DALL-E. Ten nyní bude do svých výstupů přidávat symbol v levém rohu. Ostatně u obrázků tvořených s DALL-E3 přes Bing.som/create už označení v rohu bylo.

Metodiku C2PA budou dodržovat také Midjourney, Shutterstock a nástroje od Microsoftu, Googlu a Adobe. Což samozřejmě vytváří jiné riziko. Existují i jiné AI nástroje, které nemusí být do dané iniciativy zapojeny. Uživatelé ale díky povědomí o označování budou žít v pocitu falešného „bezpečí“. Popravdě ale ani zvýšená ostražitost nemusí pomoci. Autor tohoto textu si to potvrdil u nedávného kvízu Pavla Kasíka na Seznam Zprávách založeném na rozpoznávání AI či „ne-AI“ původu fotografií. Před půl rokem platné poučky o počítání prstů na rukou nebo hledání chyb ve fotorealističnosti se stávají bezpředmětné, jde už spíše u vyložené hádání, kdy se úspěšnost blíží hodu mincí. Potvrzují to i výsledky 105 tisíc účastníků daného kvízu, které se v průměru rovnají 54 % úspěšnosti.

A co audio a video?

Přes výše řečené je AI původ u fotografií rozpoznatelnější než u nahrávek hlasu z pokročilých AI nástrojů, o textech ani nemluvě. Kvalita a dostupnost deepfake videí se také neustále zvyšuje. Jak ukázalo nedávné falešné video s ministrem vnitra Vítem Rakušanem, v němž po deepfake zásahu dehonestoval dopředu své publikum na debatě v Karviné, i mizerná kvalita poslouží. Stačí k tomu, když jsou dezinformace zaměřeny na publikum, kterému „sednou“ do jeho světonázoru.

Můj první deepfake! Nebo spíš cheapfake?

Bylo by to legrační, kdyby problematika zneužívání AI nebyla ve skutečnosti tak nebezpečná. Před bezpečnostní experty staví úkol, jak se s jejím nástupem vypořádat. My ostatní mezitím musíme používat zdravý rozum a ověřovat si… pic.twitter.com/UFTRM1iw7F

Minulý pátek zveřejněný příklad z Hongkongu pak ukazuje ničivý potenciál v případě pracovních podvodů. Muž z finančního sektoru po videorozhovoru s domnělým (ve skutečnosti deepfake) nadřízeným z Británie a dalšími (deepfake) kolegy poslal podvodníkům přes 25 milionů dolarů.

Dobře zfalšovaný hlas má mimořádnou dezinformační sílu v poměru „cena/výkon“. Jeho tvůrcům stačí jen sepsat text a zmáčknout tlačítko u dostatečně kvalitního nástroje pro převod textu na hlas. Absence vizuálu pak jen napomáhá obtížnosti rozporování pravosti.

Co může s těmito nebezpečími udělat Meta na svých platformách? Má ještě méně možností než u obrázků. „Zatímco společnosti začínají zahrnovat signály do svých generátorů obrázků, nezačaly je zahrnovat do nástrojů umělé inteligence, které generují zvuk a video ve stejném měřítku, takže zatím nemůžeme tyto signály detekovat a označovat tento obsah od jiných společností,“ vysvětluje Meta. Bude proto vyžadovat, aby „AI původ“ označovali sami uživatelé při vkládání obsahu k publikaci. Konkrétně k tomu říká:

„Zatímco odvětví pracuje na této schopnosti, přidáváme funkci, aby lidé zveřejňovali, když sdílejí video nebo zvuk generovaný umělou inteligencí, abychom k němu mohli přidat štítek. Budeme vyžadovat, aby lidé používali tento nástroj pro zveřejňování a označování, když zveřejní organický obsah s fotorealistickým videem nebo realisticky znějícím zvukem, který byl vytvořen nebo upraven digitálně, a pokud tak neučiní, můžeme uplatnit sankce. Pokud zjistíme, že digitálně vytvořený nebo upravený obrazový, video nebo zvukový obsah vytváří obzvláště vysoké riziko podstatného klamání veřejnosti v důležité záležitosti, můžeme v případě potřeby přidat výraznější označení, aby lidé měli více informací a souvislostí.“

Všichni víme, že to nebude fungovat stoprocentně. To se ostatně nedaří ani u označování placených partnerství influencery. U případných dezinformačních kampaní vedených z falešných účtů není hrozba penalizace příliš odstrašující. Meta si nicméně fandí v tom, že AI ji pomůže s odhalováním závadného AI obsahu. Jí vyvíjený open-source velký jazykový model Llama má být v dané činnosti lepší než dosavadní nástroje založené na strojovém učení.

„Jsme optimističtí, že generativní umělá inteligence nám může pomoci rychleji a přesněji odstraňovat škodlivý obsah. Mohla by být také užitečná při prosazování našich zásad ve chvílích zvýšeného rizika, jako jsou volby. Začali jsme testovat velké jazykové modely (LLM) tím, že jsme je trénovali na našich komunitních standardech, aby nám pomohly určit, zda daný obsah porušuje naše zásady. Tyto první testy naznačují, že modely LLM mohou fungovat lépe než stávající modely strojového učení. Modely LLM používáme také k tomu, abychom za určitých okolností odstraňovali obsah z front na recenze, pokud jsme si velmi jisti, že neporušuje naše zásady. Tím se uvolní kapacita našich recenzentů, kteří se mohou zaměřit na obsah, u něhož je větší pravděpodobnost, že naše pravidla poruší,“ uvádí.

Dle Meta je generativní AI zároveň mečem i štítem. Přejme si, ať jim štít dobře slouží při odvracení útoků.