Umělá inteligence od Facebooku má odhalit sebevražedné sklony

Sociální sítě jsou někdy místem posledního rozloučení. Lidé sem napíší poslední status jako finální volání o pomoc či rozloučení předtím, než spáchají sebevraždu. Než si toho někdo všimne bývá už často pozdě. A právě z tohoto důvodu Facebook spustil nový nástroj umělé inteligence, který detekuje obsah se sebevražednými sklony. Jedná se o další krok, který má vést k vybudování zdravé komunity na Facebooku.

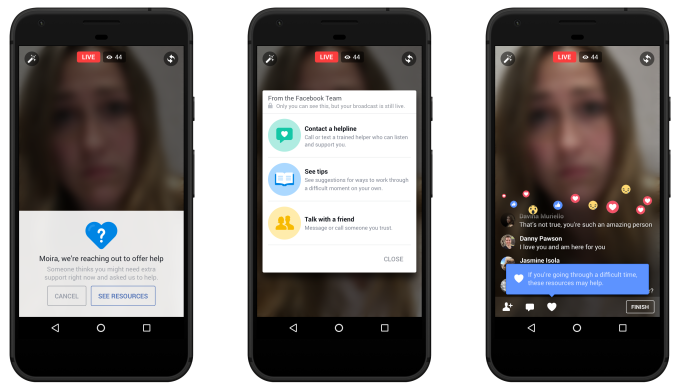

Tento nástroj s názvem „proaktivní detekce” bude skenovat jednotlivé příspěvky a videa a sledovat, zda obsahují sebevražedné myšlenky. Následně bude taková informace předána proškolenému týmu profesionálů, kteří jsou schopni poskytnout odbornou pomoc 24/7. Pokud to bude nutné, vyšlou k danému člověku zástupce z oblasti duševní péče, zkontaktují jeho přátele nebo jiné místní kontakty. Tímto by se měl významně snížit čas nutný k vyslání pomoci.

V některých případech se může jednat například o policisty a podle slov strážníků z New Yorku pomohl Facebook právě takto zachránit již několik životů.

Getting Our Community Help in Real Time Zveřejnil(a) Facebook Safety dne 26. listopad 2017

Facebook je prozatím velmi uzavřený při poskytování informací o principech, na kterých je algoritmus vystaven. Prozatím se ví, že umělá inteligence detekuje i komentáře a reakce typu: „Je všechno v pořádku?”, „Můžu nějak pomoci?” a dokáže tak odhalit situace, které by jinak zůstaly bez povšimnutí. V květnu má být přijato dalších 3 000 expertů, kteří budou monitorovat videa a další obsah.

Obavy ze zneužití

Informace o tom, že Facebook bude proaktivně skenovat uživatelské příspěvky, vyvolala i rozporuplné reakce, protože není jasné, kam až Facebook v hlídání příspěvků zajde. Bude například sledovat určité politické názory nebo drobné kriminální prohřešky?

V reakci na tyto obavy uveřejnil Alex Stamos, vedoucí bezpečnostní kanceláře Facebooku, následující tweet.

The creepy/scary/malicious use of AI will be a risk forever, which is why it's important to set good norms today around weighing data use versus utility and be thoughtful about bias creeping in. Also, Guy Rosen and team are amazing, great opportunity for ML engs to have impact. https://t.co/N9trF5X9iM

— Alex Stamos (@alexstamos) 27. listopadu 2017

V něm upozorňuje, že strašidelné, děsivé či nebezpečné využití umělé inteligence bude hrozit vždy, a právě proto je důležité stanovit správné normy už dnes. Dle něj je nutné zvážit riziko zneužití dat oproti jejich užitečnosti.

Mark Zuckerberg se k celé situaci vyjádřil i na svém Facebookovém účtu, kde mimo jiné zmínil:

„Umělá inteligence bude schopna lépe porozumět jemným nuancím jazyka a dokáže identifikovat různé problémy, jako je například sebevražda, a také různé druhy šikany a nenávisti.”

Zmíněná umělá inteligence byla několik měsíců testována ve Spojených státech amerických a postupně by se měla stát celosvětově dostupnou. Jedinou výjimkou jsou státy Evropské unie, ve které kvůli GDPR není možné profilovat uživatele tímto způsobem a nasazení této technologie je tak těžší než v ostatních státech,

Zdroje: TechCrunch , Mark Zuckerberg , The Verge , Facebook