Rasistická urážka s emoji opice projde spíše než ta bez ní. Čistící algoritmy sociálních médií to s emoji neumí

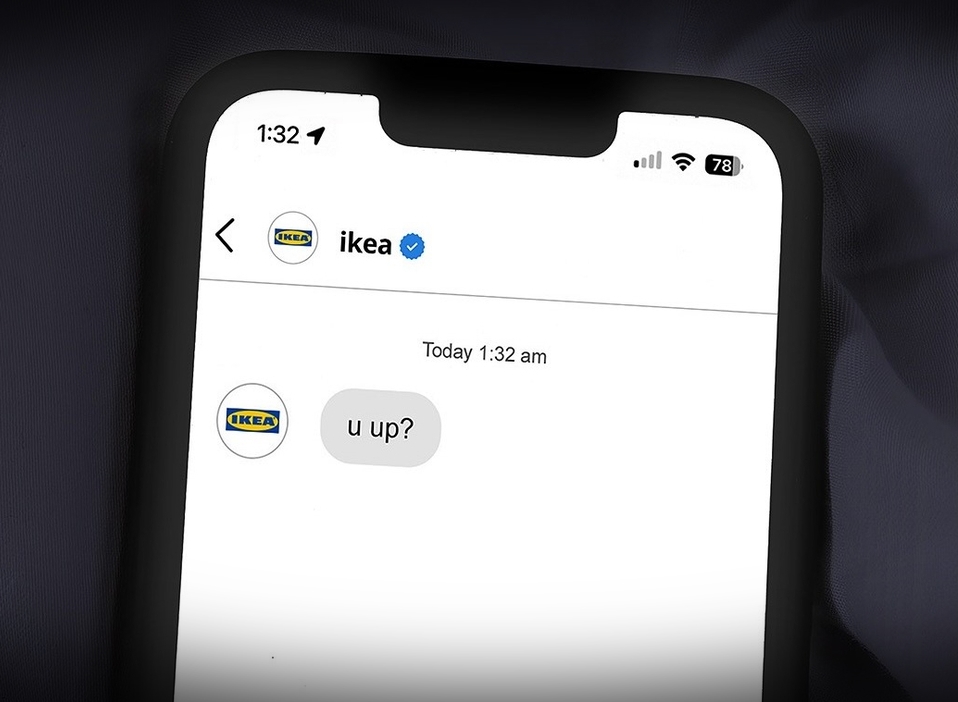

Mnoho uživatelů internetu, včetně zástupců menšin, žen a dětí, se na internetu setkalo s kyberšikanou. Sociální média jsou jedním z primárních míst, kde se urážlivé příspěvky, komentáře a zprávy objevují. Jejich vedení si uvědomují vážnost situace, a proto většina z nich pracuje na minimalizaci těchto negativních jevů. Daří se jim to ovšem jen částečně, jejich „čistící algoritmy“ totiž dokáže zmátnout i emoji vedle snůšky urážek.

Nedávná studie od Oxford Internet Institute ukázala, že příspěvky s urážlivým obsahem, které obsahují emoji jsou identifikovány umělou inteligencí jako nevhodné s menší pravděpodobností, a tak ze sociálních sítí nejsou často vůbec odstraněny. Jinak tomu je u příspěvků, které obsahují pouze text bez emotikonů. U těch je pravděpodobnost odstranění vyšší.

Příkladem může být finále Eura 2020, kdy někteří hráči Anglie, obzvláště pak neúspěšní exekutoři rozhodujících penalt, po prohře obdrželi na sociálních sítích rasistické komentáře. Algoritmy však tyto komentáře neodhalily, protože téměř všechny obsahovaly emotikon opice. Ze sociálních proto nebyly odstraněny.

Velkou příčinou toho, že systémy nejsou schopny odhalit kyberšikanu na internetu, je to, že jsou vyškoleny na databázích, které většinou obsahují text a jen zřídka emoji. Když tyto algoritmy narazí na urážlivé příspěvky s emoji, často je automaticky zařadí jako přijatelné.

Nedávná analýza odhalila, že účty na Instagramu, které zveřejňovaly rasistický obsah, ale používaly k němu emotikony, měly 3x menší pravděpodobnost, že budou zablokovány, než účty, které zveřejňovaly rasistický obsah bez emotikonů.

Díky tomuto problému se objevil výzkum od Oxford Internet Institute. Výzkumníci vytvořili novou databázi o přibližně 4 tisících větách, které obsahovaly různé emoji. Tuto novou databázi pak použili k tréninku modelu založeného na umělé inteligenci. Model byl poté testován na nenávistných komentářích, například na adresu menšin, náboženství a komunity LGBT.

Model společnosti Google s názvem „Perspective API" při testování odhalil pouze 14 %. Nový model s umělou inteligencí vytvořený Oxfordskou univerzitou zvýšil účinnost modelu společnosti Google přibližně o 30 až 80 %.

Výzkumníci po zveřejnění své zprávy sdíleli svou databázi online, aby ji mohli využít i další vývojáři a společnosti.

Zdroje: Digital Information World, Oxford Internet Institute